네트워크를 조립하는 것은 마치 레고와도 같다. 입력이 주어지면 layer을 계속 쌓았다.

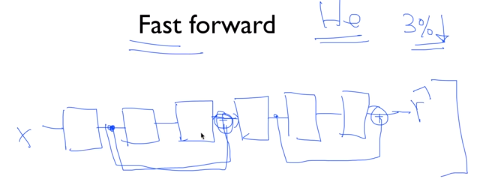

직전 결과를 바로 앞에 전달하는 것과 달리 2개 전의 결과를 전달하는 방법도 있고, 이것을 Fast Forward라고 한다.

실제로 error rate가 3% 떨어진다고 한다.

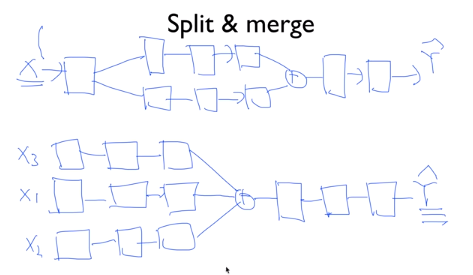

처음에 몇 개의 독립적인 NN으로 구분해서 진행한 다음 모으는 Split 방법도 있고, 처음에는 여러 개로 나눠진 데이터들을 모아서 진행하는 방법도 있다. 이것이 Convolutional Neural Network로 이어진다고 한다.

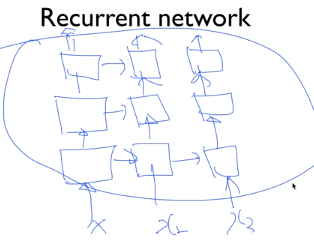

한 방향으로만 나아가지만 말고 위 그림에서 보듯이 옆으로도 나아갈 수 있고, 경우에 따라서 또다른 입력을 받을 수도 있다. 이 방법이 RNN이다.

어떤 형태이든 NN을 조합해서 만들 수 있다.

'AI > [DLBasic]모두의 딥러닝(딥러닝의 기본)' 카테고리의 다른 글

| [DLBasic] 11 - 2. CNN introduction : Max pooling and others (0) | 2020.01.20 |

|---|---|

| [DLBasic] 11 -1 . CNN introduction (0) | 2020.01.20 |

| [DLBasic] 10 - 3. NN dropout and model ensemble (0) | 2020.01.20 |

| [DLBasic] 10 -2 . Initialize weights in a smart way (0) | 2020.01.20 |

| [DLBasic] 10 - 1. ReLU : Better non-linearity (0) | 2020.01.19 |